7月14日,华为面向AI大模型时代又有大动作,发布了两款新品,为基础模型训练、行业模型训练,以及细分场景模型的训练和推理提供存储解决方案,以更好地释放AI新动能。

华为数据存储产品线总裁周跃峰发布AI存储新品

就在7天前的华为开发者大会2023(Cloud)上,华为发布了面向行业的大模型系列——盘古大模型3.0,可以提供100亿参数、380亿参数、710参数和1000亿参数的系列化基础大模型,匹配不同场景、不同时延、不同响应速度的行业多样化需求,包括NLP大模型的知识问答、文案生成、代码生成,以及多模态大模型的图像生成、图像理解等能力。

自2022年11月ChatGPT问世以来,以预训练大模型等为代表的新兴技术掀起加速了新一代人工智能的发展,全球掀起AI大模型军备竞赛。在这场竞赛中,华为除了面向行业应用推出系列大模型,也做起了AI淘金时代“卖铲人”。

AI淘金时代,华为做起“卖铲人”

AI大模型时代的三要素:算力、算法和数据。在华为数据存储产品线总裁周跃峰看来,数据以及数据的质量决定人工智能智力的高度。发展人工智能产业,要重视数据和信息的数字化记录。

据周跃峰观察,国外ChatGPT大模型的训练效率更高一些、容易一些,其核心的原因就在于在数字化阶段,更多的英文资料被记录了下来,远远多于中文资料。而我国发展了大量的数据中心,算力相对来说比较多,而存力还比较少,很多高价值的信息没有被记录下来,长此以往这将会制约我国人工智能产业的高质量发展。

而对于企业而言,在开发及实施大模型应用过程中,由于数据存储的问题也面临四大挑战。周跃峰指出,首先,数据准备时间长,数据来源分散,归集慢,预处理百TB数据需10天左右;其次,多模态大模型以海量文本、图片为训练集,当前海量小文件的加载速度不足100MB/s,训练集加载效率低;第三,大模型参数频繁调优,训练平台不稳定,平均约2天出现一次训练中断,需要Checkpoint机制恢复训练,故障恢复耗时超过一天;最后,大模型实施门槛高,系统搭建繁杂,资源调度难,GPU资源利用率通常不到40%。

在7月14日的发布会上,华为顺应大模型时代AI发展趋势,针对不同行业、不同场景大模型应用,推出OceanStor A310深度学习数据湖存储与FusionCube A3000训/推超融合一体机。

周跃峰介绍,OceanStor A310为智能数据而生,可以实现从数据归集、预处理到模型训练、推理整个的存储支撑的工作。OceanStor A310支持96闪存盘,带宽达到400G/秒。也就是说,每秒钟可以传200多部高清的电影。IOPS达到1200万,最高支持4096个节点的横向扩展。而通过近存计算实现近数据预处理,减少数据搬移,预处理效率提升30 %。

而FusionCube A3000训/推超融合一体机,则面向行业大模型训练/推理场景,针对百亿级模型应用,集成OceanStor A300高性能存储节点、训/推节点、交换设备、AI平台软件与管理运维软件,为大模型企业提供一站式的部署交付体验。

周跃峰介绍,该一体机的训/推节点与存储节点均可独立水平扩展,以匹配不同规模的模型需求。同时FusionCube A3000通过高性能容器实现多个模型训练推理任务共享GPU,将资源利用率从40%提升到70%以上。

华为数据存储产品线总裁周跃峰表示:“大模型时代,数据决定AI智能的高度。作为数据的载体,数据存储成为AI大模型的关键基础设施。华为数据存储未来将持续创新,面向AI大模型时代提供多样化的方案与产品,携手伙伴共同推进AI赋能千行百业。”

耗材死贵!“耗材刺客”越来越多,净水器、

耗材死贵!“耗材刺客”越来越多,净水器、 2020至2022年市值最大10家平台企业研发投入超

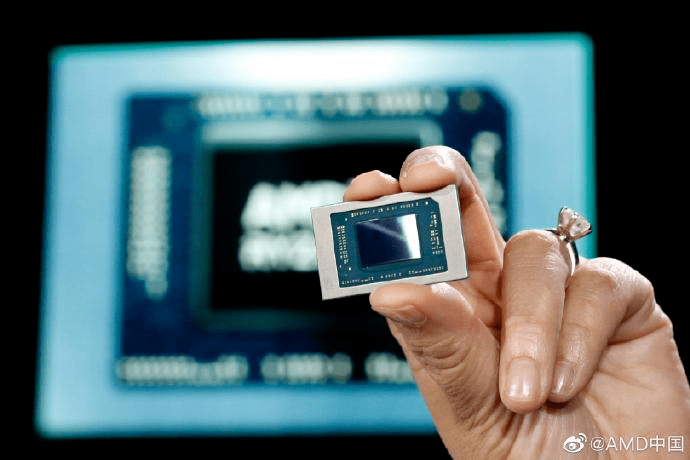

2020至2022年市值最大10家平台企业研发投入超 美国收紧对华芯片出口,三大芯片厂联合逼宫

美国收紧对华芯片出口,三大芯片厂联合逼宫 “中软国际+华为”,一起加“油”干

“中软国际+华为”,一起加“油”干 预计搭载R7 7840HS,联想预告新款ThinkBook 14+/

预计搭载R7 7840HS,联想预告新款ThinkBook 14+/ “上合小记者”遇见中国科技力量:要把见闻

“上合小记者”遇见中国科技力量:要把见闻 2023几乎零差评的4款电视盒子,涵盖高中低三

2023几乎零差评的4款电视盒子,涵盖高中低三